Les solutions BI et Analytics sont et continuent d’être une partie intégrante de l’écosystème applicatif des entreprises.

Cela est dû à une réelle prise de conscience de l’intérêt, voire de la nécessité de ces outils pour :

• Un pilotage efficient de l’activité

• Une mise à disposition rapide de données pertinentes, besoin qui va s’accentuer dans le futur afin d’accélérer la prise de décisions

• Une agilité et une rapidité dans l’exploitation des données

Dans cet article nous allons revenir sur certaines des tendances qui ont marqué les dernières années, et les nouveautés qui vont marquer le panorama du marché BI et Analytics en 2020

Les éditeurs des solutions Analytics continuent leurs efforts pour rendre leurs outils plus accessibles et mieux adéquats aux besoins et aux attentes des utilisateurs, en proposant ou en améliorant des fonctionnalités de self-service BI et de Data Vizualisation. Une lecture rapide de la feuille de route des produits des différents éditeurs permet de constater la poursuite de cette tendance, à la fois pour enrichir le contenu proposé mais également pour rendre l’utilisation de ces fonctionnalités plus simple et plus intuitive :

· IBM : IBM Cognos Analytics a également bénéficié de l’intégration de nouveaux types de graphiques (notamment le flowchart), de capacités supplémentaires de personnalisation des tableaux croisés et des graphiques, en plus de faciliter l’intégration de modèles de visuels qui ne figurent pas sur le catalogue originel.

· Microsoft : En plus d’être enrichie de nouvelles fonctionnalités pour la création des rapports, la dernière version de Power BI vient intégrer de nouveaux modèles de visuels (notamment le flowchart).

· Microstrategy : En plus d’enrichissements aux composants de cartes géographiques (notamment avec la définition de zones géographiques personnalisées), des améliorations ont été apportées à l’utilisation des hiérarchies (notamment pour des sources MDX), et de nouvelles fonctionnalités viennent enrichir l’ensemble des visuels.

· Qlik : Les dernières versions de Qlik Sense viennent apporter des enrichissements sur les possibilités de mise en forme des rapports. Diverses améliorations ont été apportées aux graphiques (indicateurs visuels, personnalisation des cartes géographiques et amélioration des infobulles, etc.).

· SAP : En plus d’améliorer les fonctionnalités d’affichage et de recherche du contenu des axes d’analyse, les dernières versions permettent plus de personnalisation des cartes géographiques et intègrent la génération de diapositives PowerPoint à partir de tableaux de bord.

· Tableau : Tableau introduit dans ses dernières versions, l’utilisation des paramètres dynamiques, simplifiant ainsi la mise à jour du contenu publié. Les dernières versions apporteront également des améliorations visuelles sur les divers graphiques, ainsi que l’introduction de l’utilisation des zones tampons dans les cartes géographiques.

· IBM : IBM Cognos Analytics introduit de nouvelles capacités de projections statistiques basées sur les séries temporelles.

· Qlik : Qlik Sense renforce ses fonctionnalités d’« intelligence augmentée » en améliorant les fonctionnalités de NLP (Natural language Processing) notamment.

· SAP : Les dernières versions de la solution viennent enrichir les fonctionnalités prédictives « Smart Predict », basées sur les séries temporelles et permettant désormais d’utiliser plusieurs informations simultanément. Ces versions viennent également enrichir les fonctionnalités de NLG (Natural Language Generation), permettant désormais une meilleure interprétation des notions temporelles. La fonctionnalité SmartInsight permet désormais une interprétation native des comptes de produits et de charges sur les dimensions de plan de comptes.

Les fonctionnalités de collaboration figurent aussi dans la feuille de route des évolutions des produits BI et Analytics, permettant ainsi un meilleur partage et diffusion de l’information.

· Microstrategy : La fonctionnalité HyperIntelligence est améliorée avec la possibilité d’une intégration avec les workflows de l’entreprise. Une meilleure intégration avec Microsoft Outlook est à constater aussi via la fonctionnalité HyperOffice. Il est également désormais possible pour des utilisateurs clés de certifier des rapports, des ensembles de données et des documents afin de garantir la fiabilité de leur contenu.

· SAP : Les dernières versions de SAP Analytics Cloud viennent intégrer de nouvelles fonctionnalités de collaboration, comme la capacité de « diffuser pour tous » ou encore des améliorations de la gestion des dossiers spécifiques aux équipes. Analytics Catalog permet désormais une meilleure exploration du contenu et la capacité de le diffuser avec des liens URL a été intégrée.

Les éditeurs continuent d’enrichir les possibilités d’intégration de leurs outils dans les divers écosystèmes applicatifs, en élargissant les possibilités de sourcing et en facilitant les fonctionnalités de transformation de la donnée.

· Microsoft. Power BI :

_ Intégrera désormais de nouveaux connecteurs LLAP Hive et Cognite,

_ Généralisera les possibilités de diagnostic des requêtes

_ Adaptera sa gestion des métadonnées, permettant l’intégration du protocole XMLA

_ Facilitera les migrations à partir de jobs Analysis Services.

· Microstrategy : Microstrategy se veut un outil fédérateur en intégrant désormais des connecteurs pour des plateformes Power BI, Tableau ou encore Qlik. Diverses améliorations ont également été apportées à l’utilisation des REST APIs et 17 nouveaux connecteurs à des applications Cloud ont été intégrés.

· Qlik : En plus d’apporter des améliorations de la performance et des connecteurs Google BigQuery, les nouvelles versions de Qlik permettront un meilleur partage et une meilleure exploration des sources de données QVD et une intégration sans couture des modules Qlik Sense et Qlik Data Catalyst.

· SAP : SAP Analytics Cloud offre désormais la possibilité de réutiliser des opérations de mapping et de transformation réalisées lors d’un import de données, à partir de jobs existants. SAC intègre également des connecteurs à de nouvelles sources de données, comme Qualtrics et plusieurs systèmes CRM, et améliore l’intégration des données à partir des systèmes BW et HANA.

· Tableau : Tableau intégrera désormais des connecteurs pour les contenus Google, plusieurs fournisseurs de stockages basés sur le Cloud, ainsi qu’à Cloudera Impala. Les nouvelles versions apporteront également une amélioration des connecteurs Salesforce et Snowflake. De plus, elles viendront améliorer les possibilités de préparation de données de façon visuelle et ergonomique.

L’évolution continue de ces fonctionnalités pose nécessairement la question du choix de la bonne solution, et à ce sujet il est intéressant de constater que les entreprises continuent à diversifier leur portfolio de solutions. Le nombre de solutions de restitution des données avoisine en moyenne 3,8[i]. Ceci est dû au fait que certaines solutions peuvent se montrer mieux adaptées en fonction des cas d’usage.

Plusieurs facteurs rentrent en jeu lorsqu’il s’agit d’effectuer le choix de la bonne solution. Il s’agit évidemment de proposer la meilleure couverture fonctionnelle aux besoins des utilisateurs, mais également la meilleure intégration dans l’écosystème applicatif et de pouvoir accompagner l’évolution de ces deux derniers éléments.

Facteurs clés de succès du choix d’une architecture BI et Analytics

| Complétude de la vision | Anticipation | Efficacité économique | Avancée technologique | Implication de l'utilisateur |

| La définition de la feuille de route informatique devra tenir compte des besoins et des attentes de toutes les parties prenantes | L'anticipation des besoins futurs et de leur évolution assurera la durabilité des investissements actuels | L'évaluation des coûts économiques devra prendre en compte les investissements immédiats mais aussi l'évolution des coûts futurs | La capacité à implémenter et tirer profit des avancées technologiques | L'inclusion des utilisateurs finaux dans le processus de sélection assurera la complétude de l’expression des besoins et assurera une meilleure adhésion au changement |

Aspects métier

| Complétude des fonctionnalités | Capacité à suivre l’évolution de l’organisation | Agilité de mise en œuvre | Analyse avancée | Acceptation et facilité d'utilisation |

| La solution fournit-elle les fonctionnalités nécessaires afin de couvrir les cas d’usage identifiés ? | L'outil pourrait-il suivre l'évolution de l'organisation au sein de la structure et des besoins des utilisateurs ? | La solution permet-elle une mise en œuvre et un déploiement simples des futures évolutions à un coût raisonnable ? | La solution fournit-elle les outils pour aller au-delà des besoins de suivi basiques et d'explorer plus en profondeur les données? | La solution est-elle suffisamment intuitive et facile à utiliser pour assurer l’adhésion au changement par les utilisateurs finaux ? |

Aspects IT

| Interopérabilité | Scalabilité | Coûts | Cloud | Mobilité |

| Capacité du système à s'intégrer facilement dans le paysage applicatif actuel et futur et assurer le niveau d'interopérabilité requis | La solution offre-t-elle la possibilité de suivre l'évolution de la volumétrie et de la sollicitation du système par les utilisateurs et les autres systèmes ? | Le coût total des licences, de la mise en œuvre, de fonctionnement et de support. | L’utilisation du Cloud peut apporter plusieurs avantages et se trouve même incontournable pour certains éditeurs | La solution permet-elle aux utilisateurs une utilisation plus mobile et plus accessible ? |

Une réponse globale aux besoins de la population des utilisateurs peut donc potentiellement passer par une architecture composée de solutions appartenant à des éditeurs différents, notamment lorsqu’on intègre dans l’équation l’ensemble des composants de la chaîne décisionnelle (Couche de stockage, ETL, outils MDM, etc.). Cela bien évidemment ne doit pas empêcher les efforts de rationalisation lorsqu’ils sont jugés pertinents et qu’ils pourraient permettre une meilleure efficacité économique et améliorer la prise en main des outils.

Ces nouvelles évolutions devraient très certainement participer à augmenter le taux d’adoption de ces solutions par la population des utilisateurs. Il est à noter que ce taux se situe aujourd’hui autour de 35%[i] mais il varie en fonction des organisations. Il est donc intéressant de constater que ce taux augmente sensiblement pour des organisations de plus grandes tailles, pour atteindre des taux de 80%[ii]. Cela est dû au fait que ces organisations mettent en place les dispositifs d’accompagnement nécessaires, prônent une culture de la donnée, mais également investissent suffisamment dans les couches de stockage et de préparation, ainsi que sur des sujets de gouvernance et de qualité de la donnée, ce qui augmente considérablement le bénéfice pour les utilisateurs finaux.

Cette hétérogénéité des usages, des sourcing et des solutions impose une gouvernance visant à garantir la fiabilité des données et la transversalité des référentiels et des éléments de langage commun, mais qui permettrait de rationaliser et d’augmenter la synergie entre les différentes populations d’utilisateurs. La finalité étant idéalement la possibilité de disposer d’une vision transverse, soit par une centralisation de la donnée et de la gouvernance associée, lorsque cela est possible, ou par une démarche de fédération lorsque cela se montre plus pertinent.

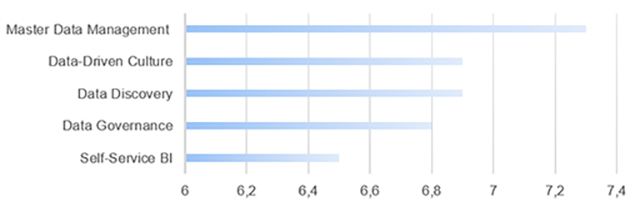

Les dirigeants semblent conscients de cette nécessité, comme le présente le résultat d’un sondage récent.

Il est certain que cette prise de conscience poussera les entreprises à s’engager dans des réflexions sur les organisations à adopter et les compétences à intégrer pour s’assurer de pouvoir tirer le meilleur de leurs données et de leurs outils.

Sources

I. https://360suite.io/fr/ebook/tendances-business-intelligence-2020/

II. https://www.gartner.com/en/documents/3956154/the-use-of-augmented-analytics-to-improve-analytic-and-b

III. https://360suite.io/fr/ebook/tendances-business-intelligence-2020

IV. https://360suite.io/fr/ebook/tendances-business-intelligence-2020